九游会J9·(china)官方网站-真人游戏第一品牌OpenAI找到了甲骨文-九游会J9·(china)官方网站-真人游戏第一品牌

裁剪:裁剪部 HYZ

【新智元导读】「算力」号称是AI时期最大的痛。在海外,OpenAI因为微软造GPU集群的速率太慢而算力告急。在国内,企业则面对着「模子算力太多元、产业生态太分散」这一难题。不外,最近新出生的一款「AI神器」,令东谈主咫尺一亮。

如今,快速纯真地获取算力可谓是刚需,就连OpenAI也不例外。

最近,The Information爆料:也曾商定微软是独家云职业器供应商的OpenAI,也曾运行找其他家要买算力了。

原因就在于,微软提供算力的速率太慢了!

OpenAI既想要微软提供更先进、算力更强的GPU集群,又要他们加速开发程度。

但微软的筹画是,在来岁年底之前为OpenAI提供约30万块英伟达GB200。

于是,OpenAI找到了甲骨文,运行洽谈一个瞻望可在2026年中赢得几十万块英伟达AI芯片的数据中心样式。

无独到偶,在算力需求这一块,国内智能算力的年复合增长率瞻望也将达到33.9%。

但在更进一步的大模子落地上,比拟起只缺算力的OpenAI,国内的企业则面对着更多的挑战,比如算力资源治理不毛、模子微调复杂等等。

模子算力太多元,产业生态太闹翻

笔据赛迪接头院的数据,2023年我国生成式东谈主工智能企业秉承率达15%,市集鸿沟约14.4万亿元。

另一方面据公开数据露馅,2023年全年,国内市集对大模子公开招投观点样式唯一不到200家,金额5个多亿;而到了2024年,仅上半年的样式就达到了486个,金额13个多亿。

其中,软件的占比在2023年为11%,而2024年上半年却唯一5%。比拟之下,大模子关连职业则从前年的17%暴涨到本年上半年的30%。也即是说,企业对大模子硬件和职业的需求,基本占了90%以上。

对比不错发现,模子应用和市集趋势之间,存在着巨大的鸿沟。

形成这一气候的原因,率先,即是大模子的幻觉问题。

大模子在预检修阶段所用的常识是通用为主,但在企业的专科领域中,若是还所以算概率来驱动的方式生硬输出,就会驴唇不对马嘴。

第二,要杀青大模子与行业场景的深度集合,应用开发经由复杂,应用门槛高。

微调、RAG都要分多个子面貌,应用开发回需要不同专科团队长期合作,研发难度大,耗时也很长。

第三,在不同场景下,不同行务对模子材干有万般需求,比如推理速率快、生成精度高、函数和代码材干强。

由于业务生成环境时时的多模并存,使用的算力资源亦然多元并用的。多模和多元的适配问题,常需要软件统共这个词重构,难度大,资本高。

此外,在产业生态上,从芯片到软件框架,再到模子自己,不同厂商的产物数据源不同、时间设施不一,很难长入适配。

在腹地化的大模子应用生成与落地中,这些挑战会愈加权臣。

怎么才能让企业(尤其是传统企业)的大模子应用赶紧落地?

这时,业内要紧地需要高效、易用、端到端的软硬一体化处治决议,来撑合手大模子行业落地。

若是有这么一种开箱即用的产物,岂论是模子自己、应用开发,如故算力问题,都能治丝而棼。

算力即得

针对这些痛点,波澜信息推出了号称AI应用开发「超等职责台」的元脑企智EPAI一体机。

从算力、平台,到职业,提供了一站式大模子开发平台。

面向果真场景,平台提供了数据处理用具、模子微调用具、增强常识检索用具、应用开发框架等。

而笔据不同模子的材干特质,平台还支合手调用多模态算法和多元算力。

最强AI算力平台

为了遮蔽不同的需求,一体机共有5种规格——基础版、设施版、立异版、高档版、集群版。

总的来说,元脑企智EPAI一体机具备了超卓的算力性能和极致的弹性架构,可支合手延时RDMA集聚和高性能并行存储。

它们通过踱步式并行加速、夹杂精度测度、高性能算子时间,进步了模子的检修和推理速率,杀青应用高并发高能效处理、业务快速上线的需求。

在检修庞大性方面,元脑企智EPAI一体机专为LLM检修微调优化提供了断点续训材干,为大模子检修添砖加瓦,优化升级算力池化与分派战略,支合手按需弹性扩缩容。

接下来,鉴识看下五个一体机不同的特质。其中,立异版、高档版和集群版均能同期支合手检修和推理。

面向模子推理的基础版配备了8块4090D GPU,性价比最高设施版则搭载了基于Hopper架构的HGX模块化AI超算平台,8颗GPU通过NVlink高效互联立异版不错为多元算力提供深度适配高档版专为那些对算力有极高需求的客户而定制,何况提供了训推全经由自动化开发测试用具链集群版,顾名念念义即是机柜级的训推一体机——为那些业务鸿沟较大,有分期开发、按需膨胀需求的企业所定制的最高配

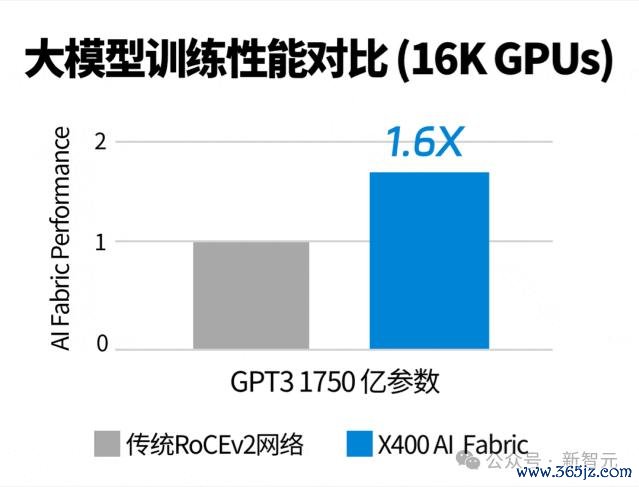

值得一提的是,在集聚单位上,集群版配备了波澜信息自研的「大模子专用交换机」——超等AI以太网交换机X400。

它最高大概膨胀到524,288张GPU的超大鸿沟AI算力系统,而且凭借AR自适应路由、端到端拥塞遣散、亚毫秒级故障自愈等时间,性能进步至传统RoCE集聚的1.6倍。

由此,大型集群杀青了超高婉曲量、高可膨胀性和超高可靠性。在LLM检修性能进步同期,也大幅镌汰检修时长、诽谤检修资本。

除了硬件上的立异以外,统共的一体机也沿路预置了元脑企智(EPAI)大模子开发平台。

这种软硬一体化托福,恰是波澜信息一体机最大上风场合。

开箱即用

有了元脑企智EPAI,波澜信息的一体机才能为企业客户们,提供开箱即用的材干。

更具体地讲,元脑企智EPAI是专为企业AI大模子应用,高效、易用、安全落地而打造的端到端开发平台。

从数据准备、模子检修、常识检索、应用框架等用具全面波及,而且还支合手诊疗多元算力和多元模子。

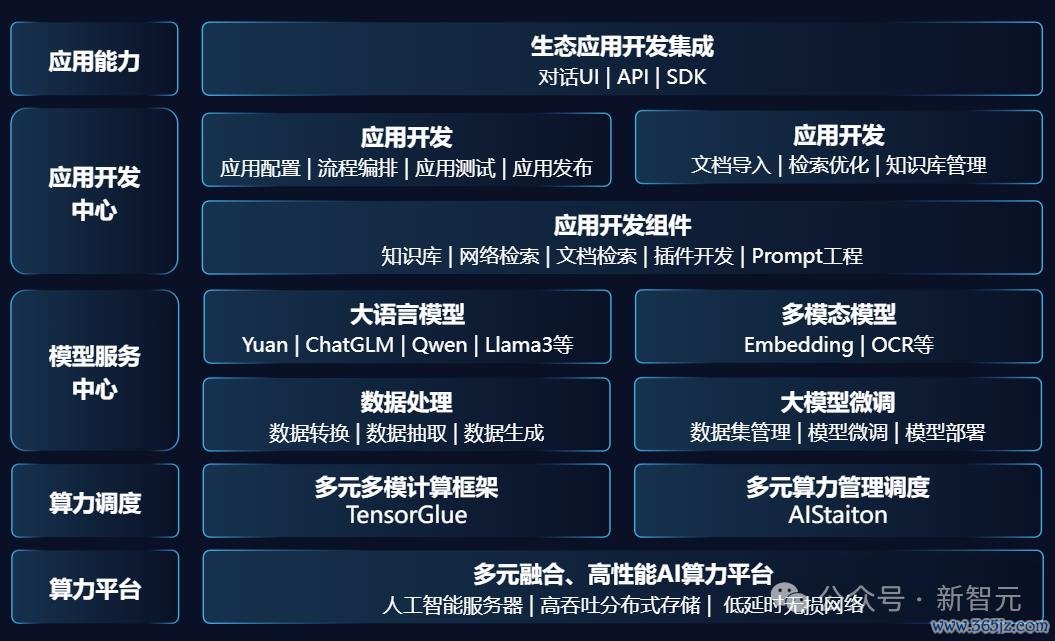

元脑企智EPAI的完好架构

多元多模

率先,元脑企智EPAI平台最中枢的一部分是,平台底座大概适配多元多模的基础设施。

多元多模测度框架TensorGlue

多模是指,支合手多种模子和多种测度框架。

其中,预置了Yuan2.0、Baichuan2、ChatGLM3、Qwen1.5、GLM4、Llama3等7个基础大模子,以及应用DEMO样例。

还有10+测度框架(MegtronLM、DeepSpeed、Pytorch、Transformer、Llamafactory、Fastchat等),以及多种微调材干,如监督微调、径直偏好优化、东谈主类反映强化学习等。

同期,它还能鄙俚支合手主流基础大模子结构,支合手与用户自研模子的纯真适配和对接。

多元算力治理诊疗AIStation

而AIStation的作用在于,大概对支合手超数千节点的AI职业器。

它不错进行异构算力集群的长入池化治理,通过自适应系统将检修底层的测度、存储、集聚环境杀青自动化建树。

从开发、检修、微调,再到应用部署,EPAI大概杀青全人命周期监管和极端全自动化处理。

而且针对不同行务场景,斥地故障自动容错,保证业务时长高效、庞大运行。

简便易用

一体机的简便易用,便体目前了数据准备/生成、微调检修、推理部署中,沿路杀青自动化。

从企业大模子开发部署业务经由来看,具备通用常识的LLM,就像刚毕业的大学生相同,需要学习企业常识。

因此,第一步数据最重要。

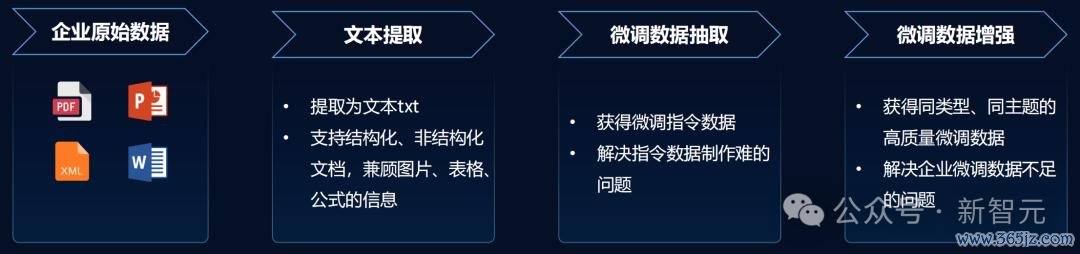

高质地数据自动生成

现时互联网检修数据远远不及,尤其是专科化的数据,而AI数据生成恰好能弥补这一瑕玷。

高质地数据,才是保险AI模子应用收尾的第一因素。

那么企业如安在种类万般、鸿沟浩大数据库中,生成微调数据,并减少处理资本?又该怎么将专科化数据为模子所用?

元脑企智EPAI平台通过高质地数据生成,攻破了难题。

企业仅需将原始数据上传,元脑企智EPAI将其索求为文本txt,各式结构化/非结构化文档均可支合手。

然后期骗大模子生成问题谜底对,也即是不错径直微调使用的数据。

临了一步通过「微调数据增强」让AI再自动生成同类型、同主题高质地微调数据。

这一过程,还会对数据抽取后,进行向量编码。

举个栗子,「Apple」会被编码成很长一个向量,其中含了许多丰富的语义信息。它可能代表生果一类,也可能代表苹果公司等等。

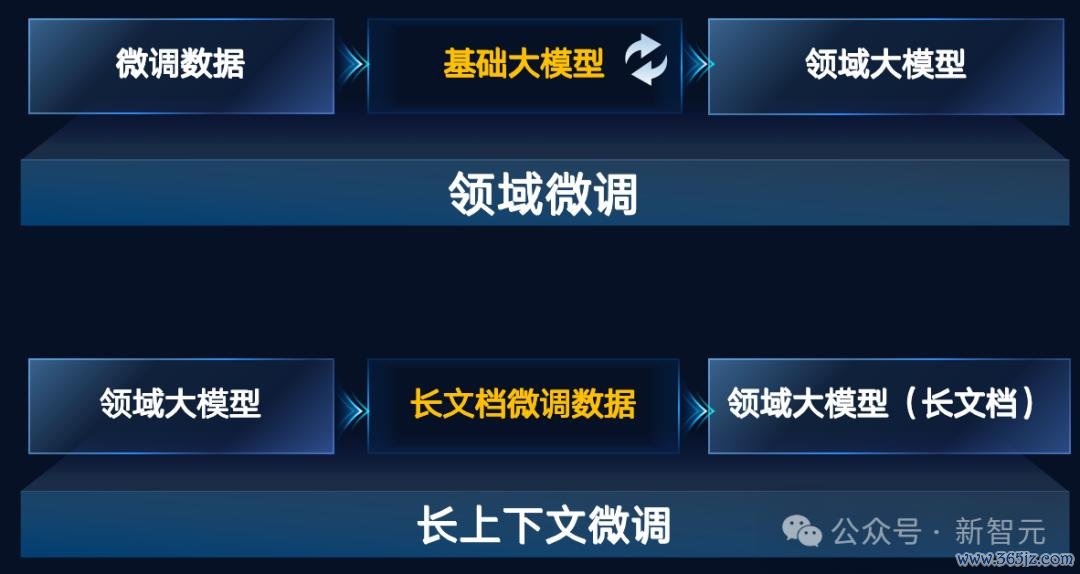

全链路微调检修用具

有了数据,接下来就要微调模子了。

好在元脑企智EPAI平台对LLM微调时所需的环境、框架、建树代码等一系列经由,完成了封装。

开发者无需脱手写代码,就能微调出领域大模子。

从数据导入、检修参数建树、资源类型建树等均由平台自动治理,大幅进步微调任务的效能。

检修微调完成后,模子部署和上线亦然由元脑企智EPAI接办,还提供了多种评估的方式。

总之,高效的数据处理用具,支合手微调数据自动生成和膨胀,为模子微调检修提供丰富数据源;丰富、完好的模子检修用具,支合手SFT优化方式,检修之后支合手一键部署。

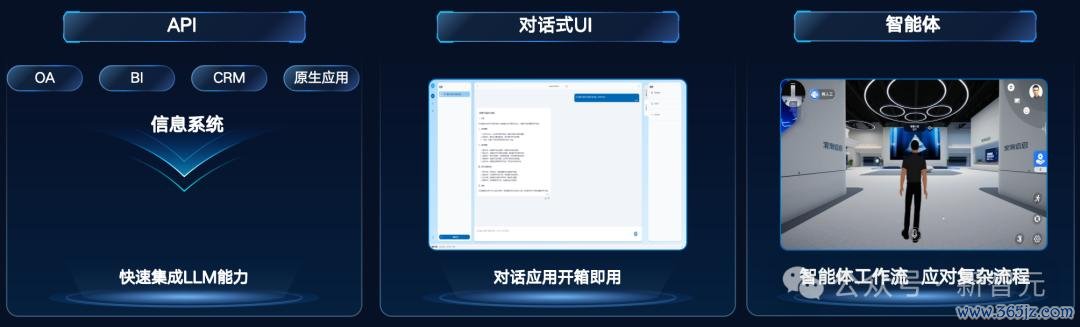

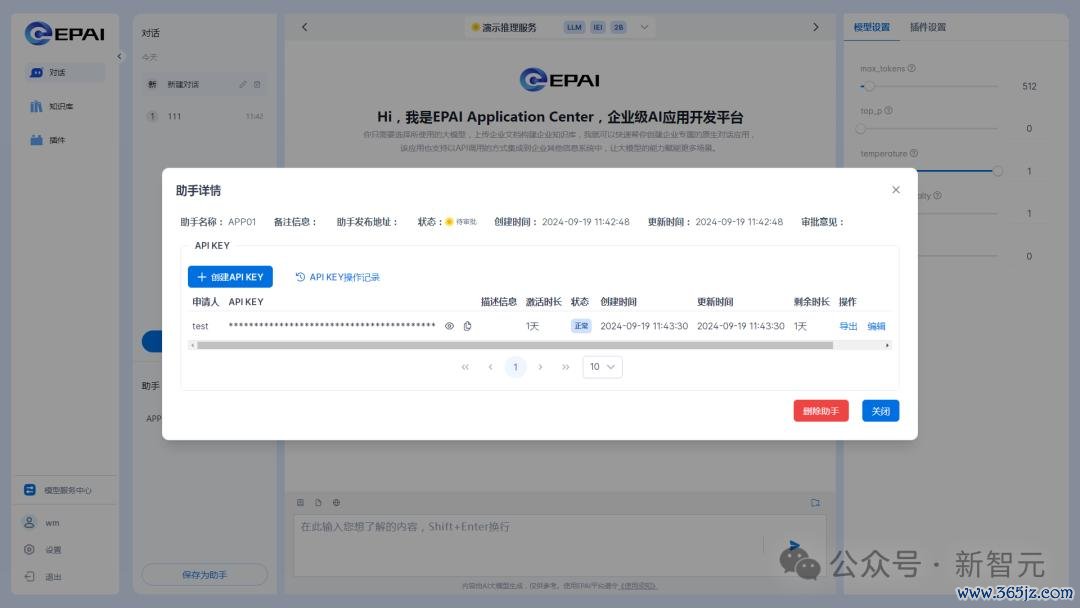

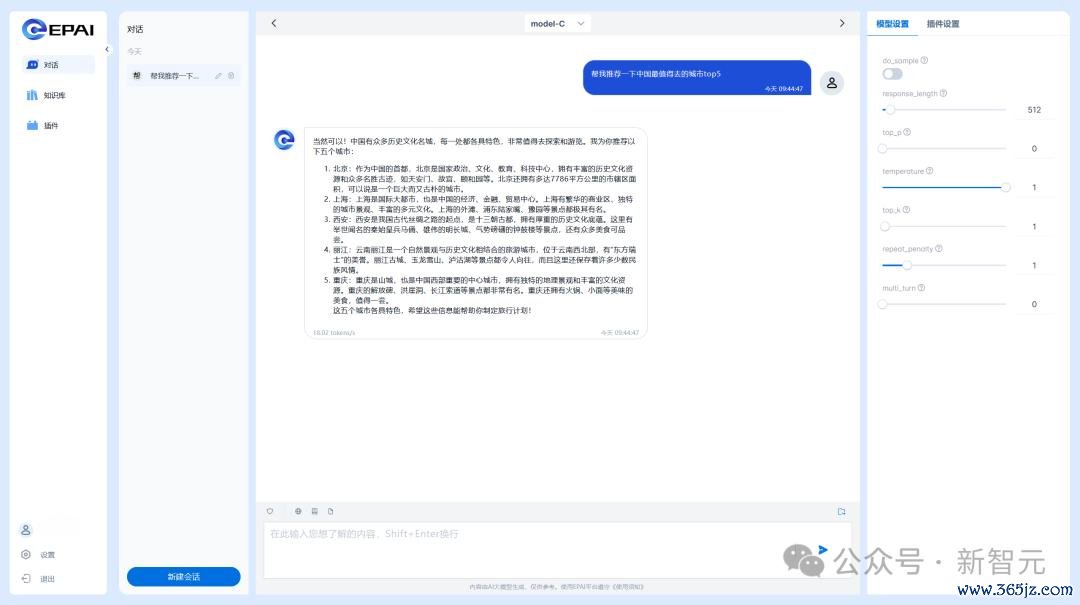

此外,元脑企智EPAI还支合手API、对话式UI、智能体三类使用方式。

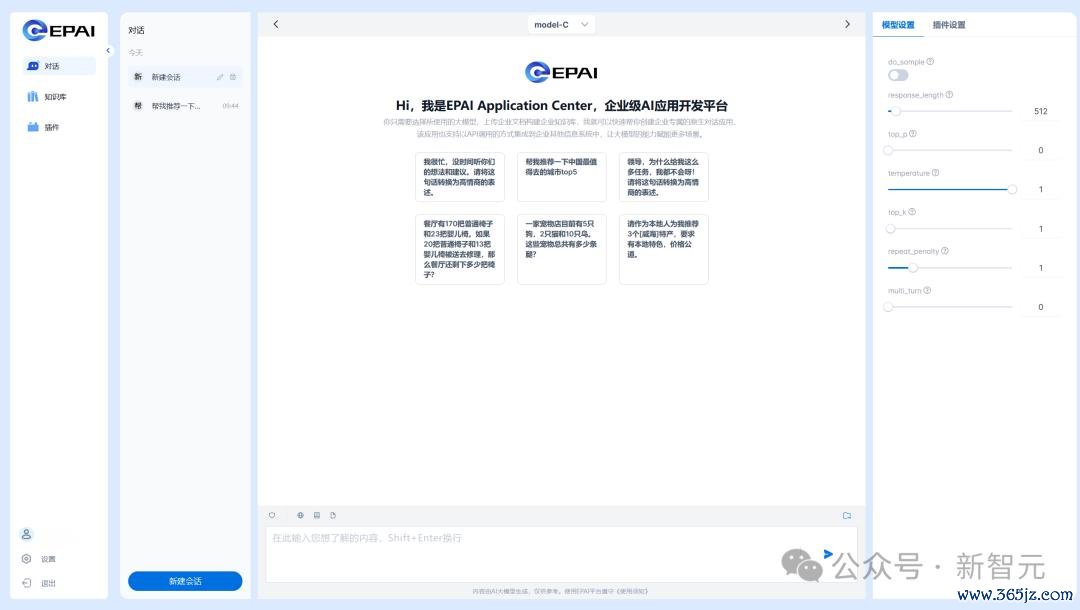

如下是对话式UI界面的阵势。

支合手RAG,弥补LLM常识无法实时更新难题

另外,还需琢磨的一个问题是,LLM幻觉之所产生,是因为无法实时获取到新常识。

而元脑企智EPAI集成了波澜信息自研的RAG系统,匡助大模子进步了应用收尾。

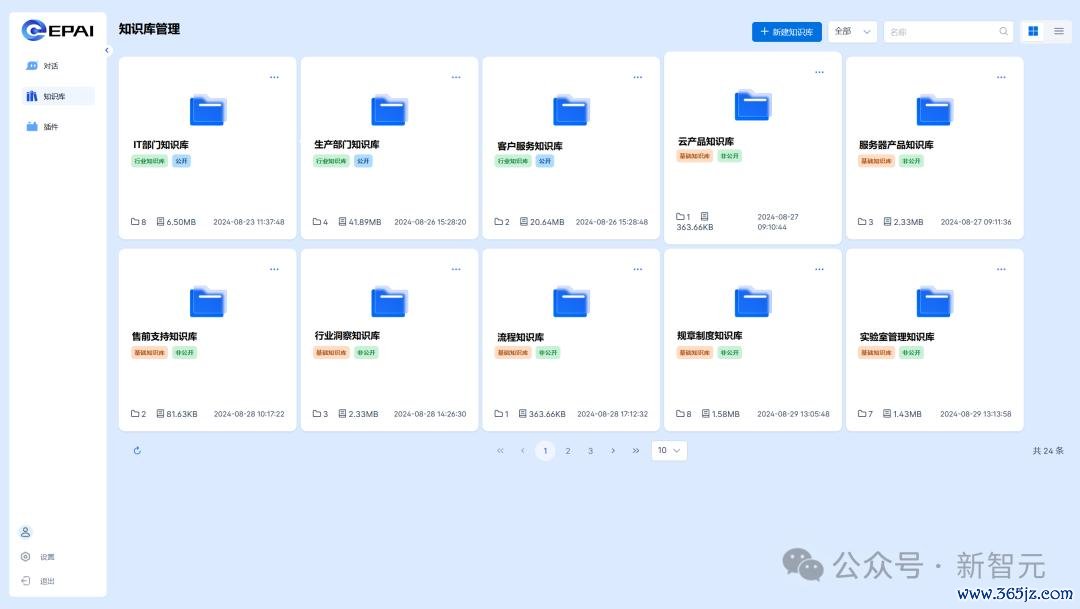

仅需上传一个原始文档,就不错让LLM基于文档实质,进行精确问答和信息检索,快速构建出领域问答材干。

同期,它还预置了一亿条的基础常识库,大概杀青端到端30%调回率。

在话式UI界面中,常识库治理中不错上传企业、行业、基础三大类常识。

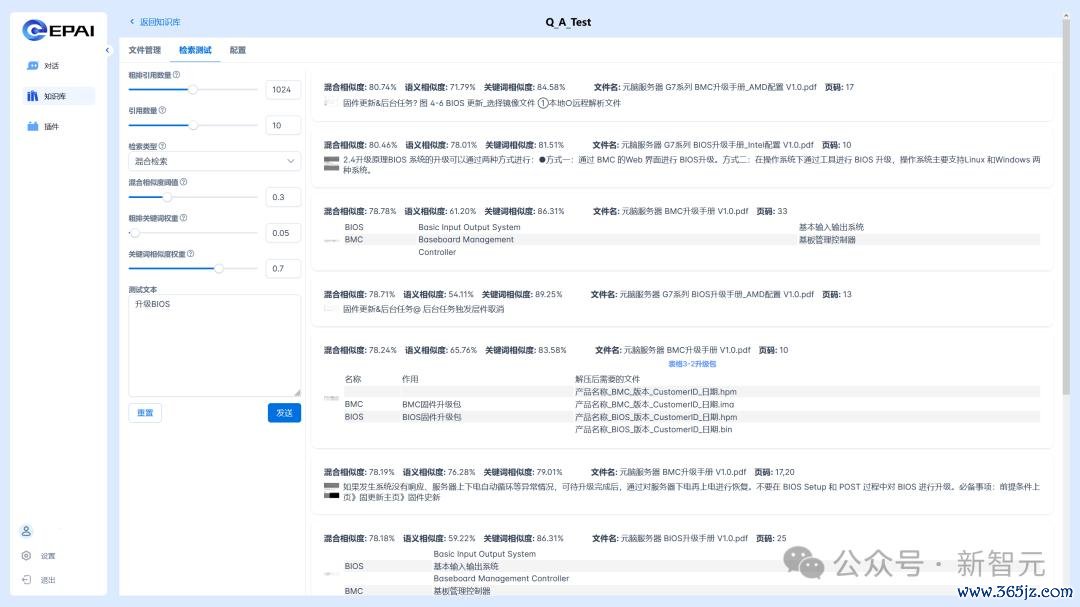

它还支合手检索溯源、夹杂检索、收尾重排,由此不错进步端到端检索精度。

数据安全,心事保护

一体机另一个上风在于, 大概保护企业的私特别据不出域,阻绝数据风险。

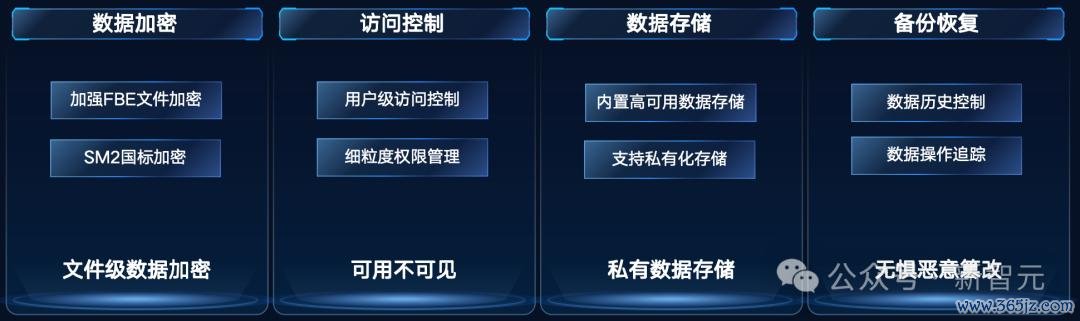

内置的元脑企智EPAI平台,不错提供全链路的珍重,从文献级数据加密、考察遣散,到数据存储、备份规复。

它不错精确遣散每个用户数据、模子、常识库、职业的权限,保险多场景使用安全。

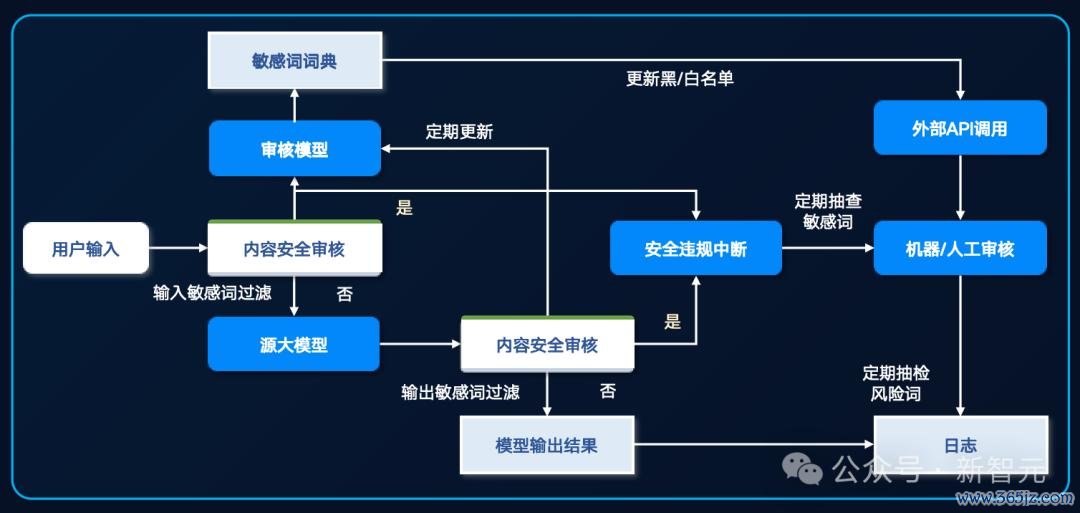

还有实质多级过滤和审核体系,对用户输入、模子输出进行快速、准确审核,保险生成实质的安全性与心事性。

AI应用,每个企业都可开发

恰是因为有以上万般上风,元脑企智EPAI能鄙俚地赋能企业里面的各种应用场景。

比如研发的代码生成、部门助理,坐褥的故障识别、维修决议生成,销售的智能客服、案牍合作,行政的招聘助手,公文写稿等。

开发速率快到低至1周,培训周期短到最快3天。

在波澜信息里面,元脑企智EPAI就也曾大大加速了世界的职责流。

过去若是特别百万行私有代码,详确少,可读性差,需要参考几十页高下文的PDF,专科工程师单个函数开发就需要3周。

但目前波澜信息期骗智能编程助手,不错径直把开发周期镌汰至2天。

它能对数十万行代码自动领路,由AI自动生成跳跃65%的测度框架代码,为研发工程师每天从简了近3个小时的代码。

而基于元脑企智EPAI打造的智能客服大脑「源小服」,涵盖了10+年的产物尊府和5000+复杂场景,径直学习了2万余份产物文档、用户手册,百万余条对话等材料。

关于常见时间问题的处治率达到了80%,全体职业效能进步了160%,斩获了《哈佛交易批驳》「鼎革奖」的年度新时间打破奖。

百模争霸,不再卡在落地

因为具有以上上风,元脑企智EPAI一体机就为用户处治了燃眉之急。

其中一类要紧客户,即是传统制造业客户。

尤其是大型制造业客户,岂论是CIO、团队,如故三产公司,在数据、东谈主员、时间方面都有许多辘集,而应用自己也有应用牵引的趋势。

而另一类,即是传统的ISV(独处软件开发商)客户。

关于他们,波澜信息有上百号博士团队在作念算力、算法、框架的应用开发职责,在算力上也很强,上风昭着。

还有一些用户,需要有对大模子成心的调优材干。

目前的情况是,关于相称专科的应用领域,国内能卖关连职业未几,花很高的代价,也就怕找得到。

正本波澜信息有这个材干,但莫得怒放。如今,波澜信息把指示、职业都集成到了一体机的产物中,正值知足了他们的需求。

在波澜信息看来,如今大模子落地的最大痛点,不是算法,也不是产物,而是行业的know-how。

若是数据不ready,也很难通过一个用具、一个软件或一台斥地去处治。

但这时若是有一个一体机的产物,还能跟懂行业、懂数据但不懂AI的ISV彼此赋能,大模子的落地就会变得很容易。

从2021年运行到目前,波澜信息已成行业里的骨灰级玩家。比如2021年作念完源1.0后,22年波澜信息就也曾在用RAG作念里面智能客服系统。

如今,凭着对模子自己的know-how,以及模子使用上的know-how,波澜信息再次赋能我方的合作伙伴,加速企业大模子应用开发,买通了大模子落地临了一公里的难题。

参考尊府:

https://mp.weixin.qq.com/s/dy_ca32xbWZslLveal2Nuw九游会J9·(china)官方网站-真人游戏第一品牌